超越 API:MCP 如何成为 AI 时代的“万能适配器”?

TL;DR

API 作为数字世界的连接纽带,虽推动了开放生态的繁荣,却因协议碎片化、开发高成本陷入“巴别塔困境”。MCP(模型上下文协议)的诞生,标志着 AI 交互范式从“人工编码适配”迈向“机器自主协作”。通过标准化服务描述与上下文感知机制,MCP 成为 AI 时代的“万能适配器”——既消除工具间的协议鸿沟,又支持运行时动态编排,使 AI 应用能像“热插拔硬件”一样自由调用跨领域服务。

本文将从 API 的历史演进、MCP 的设计理念、 以“帮我查询周末的天气,如果下雨就推荐附近的电影院”一个简单场景为例,展示 MCP 如何实现 AI 应用的智能编排,助力 AI 应用实现“所想即所得”的认知革命。

从代码接口到数字生态的基石

关键词:标准化、能力复用、开放。

API(Application Programming Interface,应用程序编程接口)是软件系统之间交互的标准化接口,它定义了数据交换的规则和协议。从手机 App 到云计算平台,API 支撑着现代数字世界的运行。

萌芽:本地化代码接口

上个世界 60 年代,UNIX 操作系统率先使用系统调用(System Call),如文件读写 open()、write() 等,为应用程序提供了访问操作系统资源的接口,成为 API 的雏形。随着结构化编程的兴起,API 逐渐演变为函数库(Library),如 C 语言的标准库 stdio.h、stdlib.h 等,提供了更高级的接口。

网络化:跨系统通信协议

随着计算机网络的发展,不同计算机之间的通信也需要标准化接口,于是网络协议诞生了,如早期的 CORBA 通用对象请求代理架构、DCOM 分布式组件对象模型,再到上世纪末的 SOAP 简单对象访问协议 为跨系统的通信提供了协议基础。这些都是早期 Web API 的雏形。

Web:REST 与开放生态

进入新千年,Web 2.0 的兴起,互联网应用迅速发展,API 也进入了新的阶段。RESTful API 成为主流,它基于 HTTP 协议,使用 URL、HTTP 方法等标准化的方式,实现了资源的增删改查等操作。

Web API 的爆发随之而来的是开放平台运动,如 Facebook、Twitter 等开放 API,让第三方开发者可以访问平台数据,构建出丰富的应用生态。

成熟:标准化与多样性

现代 Web API 如 OpenAPI、GraphQL、gRPC 等,进一步提升了 API 的开发效率和易用性。随着 API 的成熟,出现了一大批以 API 为核心商业模式的公司。API 即产品的出现,带来了 API 经济的崛起。

与此同时,通过标准化 API 解耦系统组件,实现了基础设施的弹性、可观测性和可扩展性,以此为核心的云原生技术带来了现在基础设施的变革。

趋势展望:全域互联与认知革命

随着物联网、5G 、边缘计算等技术的发展,我们迎来了超大规模的 API 网络。各种各样的设备、传感器、服务都通过 API 连接在一起,构成了数字化的生态系统。

风头正盛大模型不只是通过 API 对外提供服务,还会通过 API 与其他服务进行交互,实现更高级的认知决策。

从机械式指令到认知决策

关键词:系统、决策、热插拔

大模型的出现,为 API 的智能化交互提供了新的机会,如自然语言处理、多模态交互、自主决策等。实现了 API 的交互模式完成了从机械式指令、资源化操作到语义化交互、认知型决策的演进。

这一转变,将原本面向机器通信,强调功能和数据调用的 API,转变为面向 AI 交互。

“方言“林立:API 的巴别塔困局

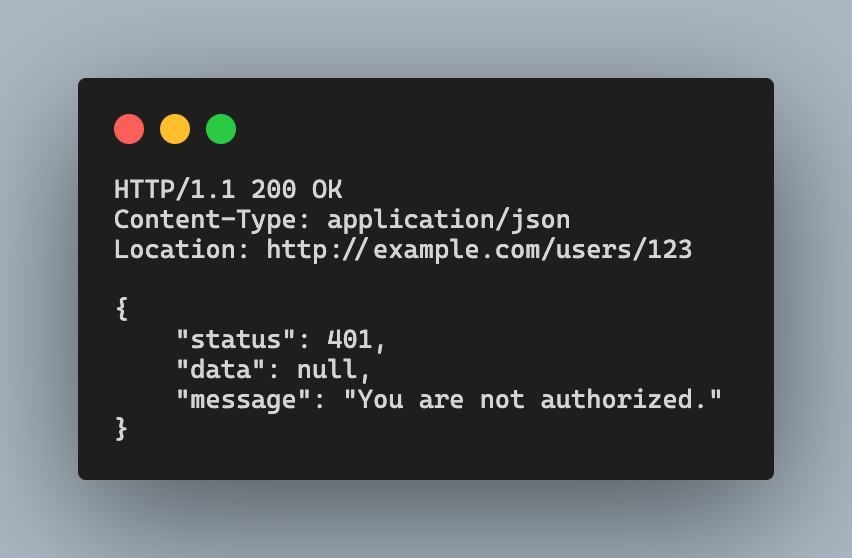

假设我们想将一个外部服务集成到我们的应用中,我们可以通过 API 调用的方式,将外部服务的功能引入到我们的应用中。此时,我们需要阅读该服务公开的 API 文档,了解 API 的功能、参数、调用方式等,然后编写代码调用 API,实现功能的集成。

如果需要集成更多的能力,我们需要调用更多的 API,编写更多的代码。由于 API 的生态多样性,不同的 API 在协议、参数、调用方式等方面都有所不同,API 的巴别塔困局使得开发者需要花费大量时间和精力去理解和调用不同的 API、处理调用异常,还需要编写大量的粘合代码来实现不同 API 之间的数据转换和调用。

这一切都是在设计阶段实现的,应用与 API 之间是强耦合的关系,扩展、升级、替换 API 都需要重新设计和开发。

LLM 驱动:以智能跨越鸿沟

大模型 LLM 可以理解自然语言,自然也可以理解结构化的 API 文档并与之交互。学习 API 的负担从开发人员转移到了大模型,这一学习过程甚至可以在运行时进行,并持续进行。

这一方式有可能颠覆传统的 API 集成模式,从“人工编码适配”转向“机器自主学习”,成为破解 API 巴别塔困局的关键路径。

举个例子,用户输入指令 “帮我查询周末的天气,如果下雨就推荐附近的电影院”。大模型可以自动识别这一需求,并调用设备 API 获取位置信息、调用天气 API 获取未来的天气状况、调用地图 API 根据位置信息获取附近的电影院,最终将结果返回给用户。这个过程中,涉及了多种 API 的调用、决策逻辑的处理,以及上下文数据的传递。

但要让这一愿景真正落地,仅靠大模型的语义理解能力并不足够。当多个 API 的调用逻辑嵌套、上下文数据需要跨系统流转时,如何确保不同协议的参数对齐?如何处理调用异常,避免流程的中断,提供备选方案。

试想:当用户说“如果下雨就推荐电影院”,大模型首先要理解各个 API 的能力,明确 API 的使用场景和调用方式。执行是要记住“下雨”状态并传递给地图 API,还需要确保这一状态在设备定位、天气服务与影院推荐服务之间无缝同步——**这才是跨越巴别塔的真正桥梁:既让机器听懂人言,又让机器之间说同一种语言。

MCP:语义一致性基座

2024 年 11 月 Anthropic 公司发布了 MCP(Model Context Protocol) 协议,这是一个开放协议,旨在为 AI 应用向大模型提供环境上下文建立标准化接口。

MCP 如同人工智能领域的 USB-C 接口,通过统一的数据接入标准,使各类 AI 模型能够无缝对接多样化数据源及功能工具。其核心价值在于构建通用连接规范,实现模型与外部系统的高效互操作性。

MCP 是典型的客户端 - 服务器架构。服务器端提供特定的功能,应用程序通过客户端来使用服务器端的功能。客户端与服务器端是一对一的关系,维护者二者之间的通信(目前有两种方式:标准输入输出和 SSE),使用 JSON-RPC 2.0 作为消息格式。

MCP 的目标建立一个所有机器都能理解的“世界语”,通过标准化上下文传递、协议转换和意图映射,让跨系统协作像单系统般自然流畅。这是实现“机器自主协作”而非“人工编码适配”的关键基础设施。

上下文感知的“粘合剂”

在跨服务的调用链中(如“查天气→推荐影院”),MCP 自动维护上下文状态(如用户位置、天气状态、影院筛选条件),确保数据在流程中无损传递。

通过引入不同的 MCP 服务器,应用程序可以变身成为多面手。例如,通过引入天气服务 MCP,应用程序可以查询天气信息;通过引入地图服务 MCP,应用程序可以查询地图信息。这样,应用程序可以通过 MCP 与不同的服务进行交互,实现更多的功能。

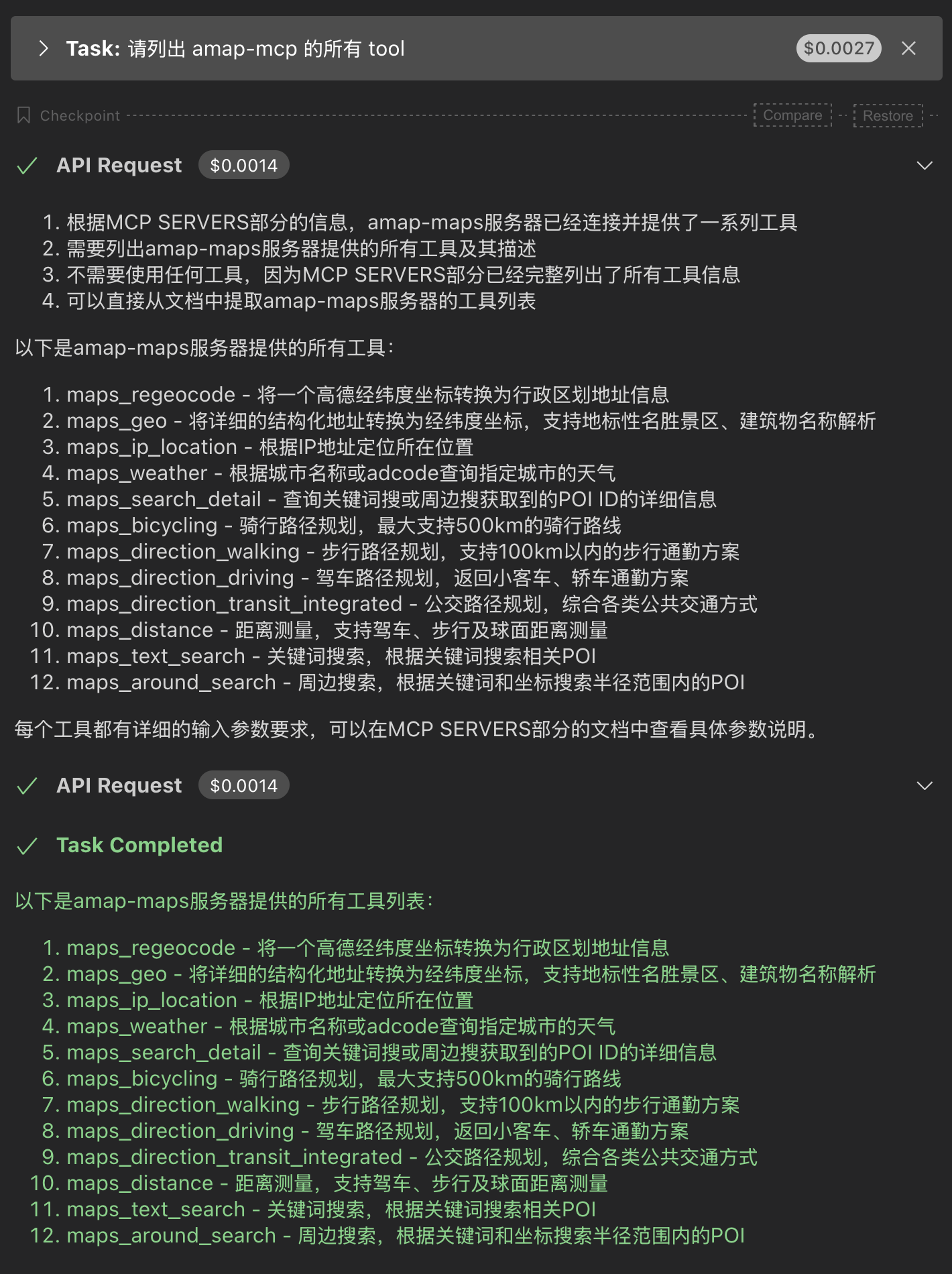

声明式服务

MCP 通过声明式服务描述,将服务的能力、输入输出、调用方式等信息进行标准化,使得大模型可以获取并理解服务的能力,自动调用服务,实现服务的智能编排。

{

"mcpServers": {

"amap-maps": {

"command": "npx",

"args": [

"-y",

"@amap/amap-maps-mcp-server"

],

"env": {

"AMAP_MAPS_API_KEY": "KEY"

}

}

}

}

只需将服务通过声明的形式描述出来,大模型便可以自动获取服务的能力。在应用连接到 MCP 服务器后,会自动从 MCP 服务器获取服务的能力。所以,当我们询问该服务器都有哪些能力时,可以即刻返回功能列表,无需调用任何工具。

服务智能编排

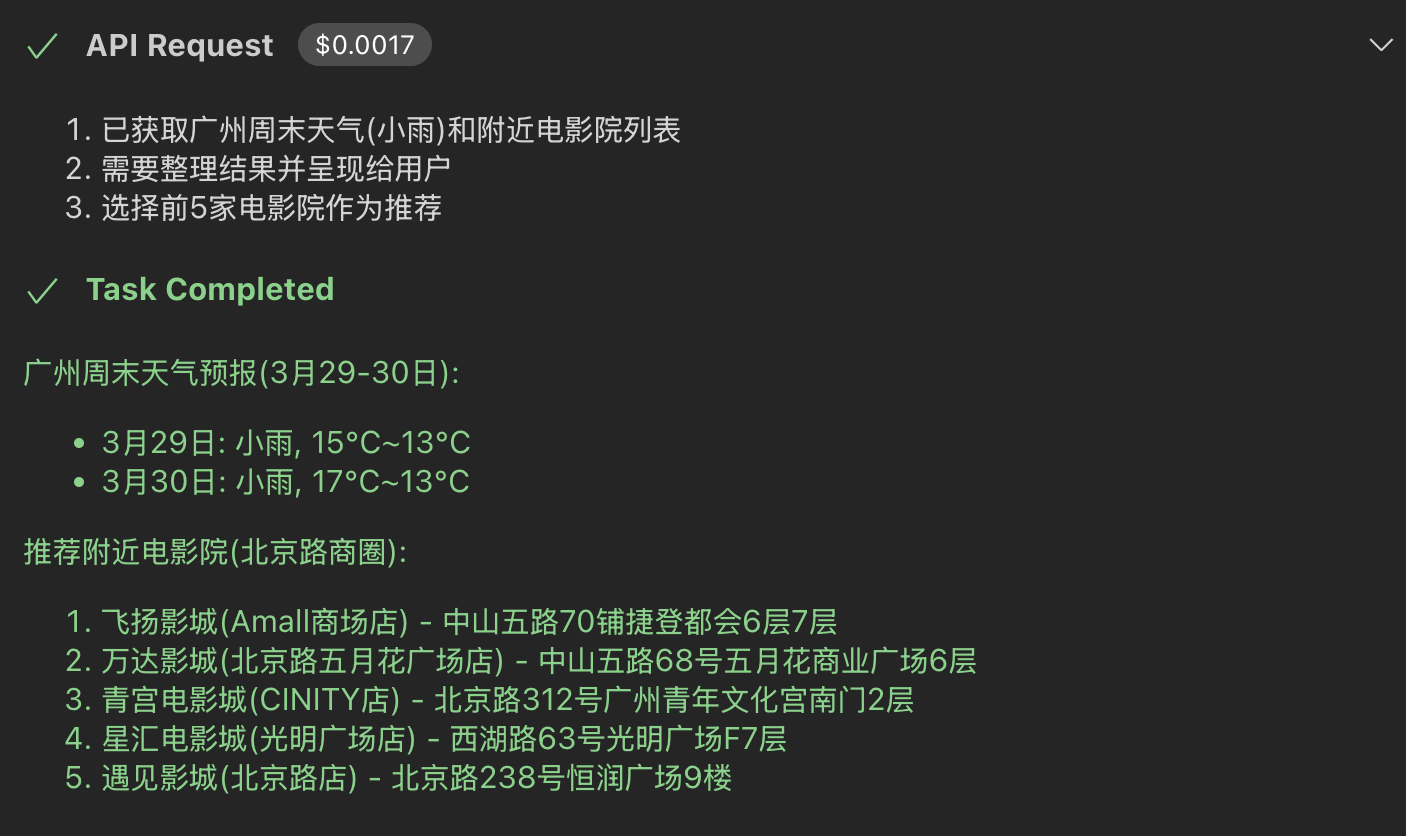

通过 MCP,大模型可以获取服务的能力,自动调用服务,实现服务的智能编排。例如,用户输入“帮我查询周末的天气,如果下雨就推荐附近的电影院”,大模型会自动编排决定功能的调用顺序:

- 调用定位服务获取用户位置信息。这里由于获取 IP 地址失败,应用自动提供交互界面,不会中断流程。(我选择了广州)

- 根据获取到的位置信息以及当前的时间,调用天气服务获取周末的天气信息。

- 如果天气信息显示周末会下雨,调用地图服务获取附近的电影院信息。(正好广州周末会下雨)

能力热插拔

这让我想起小时候看过的动画片正义战士(Centurions)中的装备升级。每次战斗前,他们可以根据不同的敌人和战场情况,选择不同的装备。装备通过太空中的空间站投送到战场上,战士们可以快速更换装备,加入战斗。

通过 MCP,应用程序可以动态添加、删除服务,实现能力的热插拔。这点与传统 API 在设计阶段的集成方式方式不同,MCP 可以实现在运行时动态添加服务,实现功能的快速扩展。

展望

未来,MCP 或将成为 AI 服务生态的“神经系统”:在更多场景中协调多模态设备/服务,在决策中串联数据分析与认知模型,甚至成为通用 AI Agent 的底层协作协议。

随着工具生态的完善,MCP 将推动 AI 应用从“功能固化的程序”进化为“自主进化的智能体”,最终实现“所想即所得”的认知革命。